好玩到停不下来的 DALL-E 3

最近 ChatGPT 对 Plus 用户逐步开放一些多模态的功能,包括 DALL-E 3(图像生成)、 GPT-4V(图像识别),等,很多网友乐此不疲地对这些新功能进行试用,目前已经解锁了不少有趣的玩法,笔者将这些好玩的功能进行了整理并介绍给大家,希望能给大家带来一些灵感。

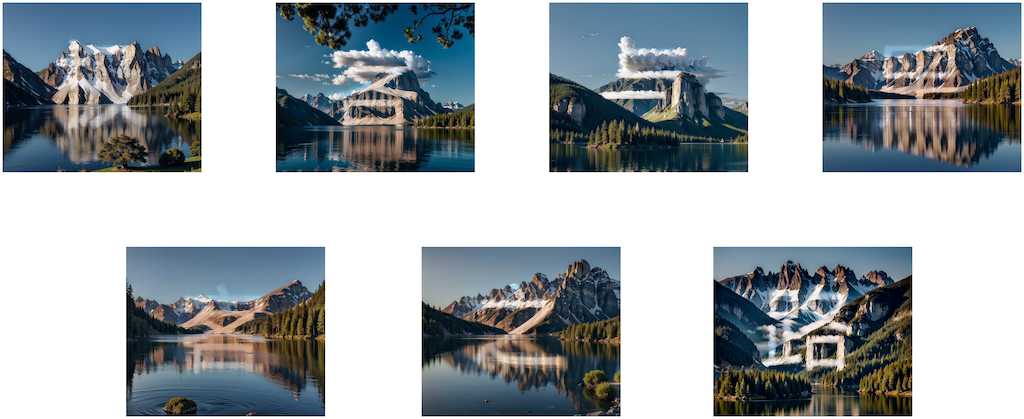

使用 API 生成 Stable Diffustion 文字和二维码隐藏图片

Stable Diffusion 前段时间有几个比较火的效果,一个是将文字隐藏在图片中,放大看时是一张正常图片,缩小看却可以看到图片中的隐藏文字,另外一个效果与前者类似,但是图片中隐藏的是一个二维码,通过扫描图片可以进入二维码中的网址。由于出图效果好,很多人想要根据自己的需求制作这种图片,甚至有人在网上出售这种图片的定制服务。今天我们就来介绍下如何使用 API 的方式 在 Stable Diffusion 中实现这种效果。

Semantic Kernel —— LangChain 的替代品?

微软在 AI 领域的探索和投入从未间断,它不仅在前期对 OpenAI 进行了大量投资 ,还在其搜索引擎 Bing 和云服务 Azure 上集成了 ChatGPT,以增强用户体验和服务能力。最近,微软更是推出了一个名为 Semantic Kernel 的 AI 应用开发工具,旨在与 LangChain 竞争,展现了其在 AI 应用开发领域的持续创新和努力。今天我们就来了解下 Semantic Kernel 的特点和功能,以及它与 LangChain 的区别。

使用 LangChain 生成海报文案

最近看到某平台在推 LangChain 的课程,其中有个示例是让 LangChain 来生成图片的营销文案,我觉得这个示例挺有意思的,于是就想自己实现一下,顺便加深一下 LangChain 的学习。今天就介绍一下如何使用 LangChain 来实现这个功能,并且介绍其中的实现细节,看完保证你也可以自己实现一个类似的功能(源码在文章最后放出)。

Docker 远程API安全问题

LangChain 自定义LLM

Langchain 默认使用 OpenAI 的 LLM(大语言模型)来进行文本推理工作,但主要的问题就是数据的安全性,跟 OpenAI LLM 交互的数据都会上传到 OpenAI 的服务器,企业内部如果想要使用 LangChain 来构建应用,那最好是让 LangChain 使用企业内部的 LLM,这样才能保证数据不泄露。LangChain 提供了集成多种 LLM 的能力,包括自定义的 LLM,今天我们就来介绍一下如何使用 LangChain 来集成自定义的 LLM 以及其中的实现原理。

LangChain Agent 原理解析

LangChain 是一个基于 LLM(大型语言模型)的编程框架,旨在帮助开发人员使用 LLM 构建端到端的应用程序。它提供了一套工具、组件和接口,可以简化创建由 LLM 和聊天模型提供支持的应用程序的过程。LangChain 由几大组件构成,包括 Models,Prompts,Chains,Memory 和 Agent 等,而 Agent 是其中重要的组成部分,如果把 LLM 比做大脑的话,那 Agent 就是给大脑加上手和脚。今天就来带大家重点了解一下 Agent 以及它的工作原理。

AI 模型量化格式介绍

在 HuggingFace 上下载模型时,经常会看到模型的名称会带有fp16、GPTQ,GGML等字样,对不熟悉模型量化的同学来说,这些字样可能会让人摸不着头脑,我开始也是一头雾水,后来通过查阅资料,总算有了一些了解,本文将介绍一些常见的模型量化格式,因为我也不是机器学习专家,所以本文只是对这些格式进行简单的介绍,如果有错误的地方,欢迎指正。

HugggingFace 推理 API、推理端点和推理空间使用介绍

接触 AI 的同学肯定对HuggingFace有所耳闻,它凭借一个开源的 Transformers 库迅速在机器学习社区大火,为研究者和开发者提供了大量的预训练模型,成为机器学习界的 GitHub。在 HuggingFace 上我们不仅可以托管模型,还可以方便地使用各种模型的 API 进行测试和验证,部署属于自己的模型 API 服务,创建自己的模型空间,分享自己的模型。本文将介绍 HuggingFace 的推理 API、推理端点和推理空间的使用方法。